Содержание:

Ключевые направления применения ИИ в бизнесе в России

Правовое регулирование в сфере ИИ

Правовые угрозы для бизнеса при использовании ИИ

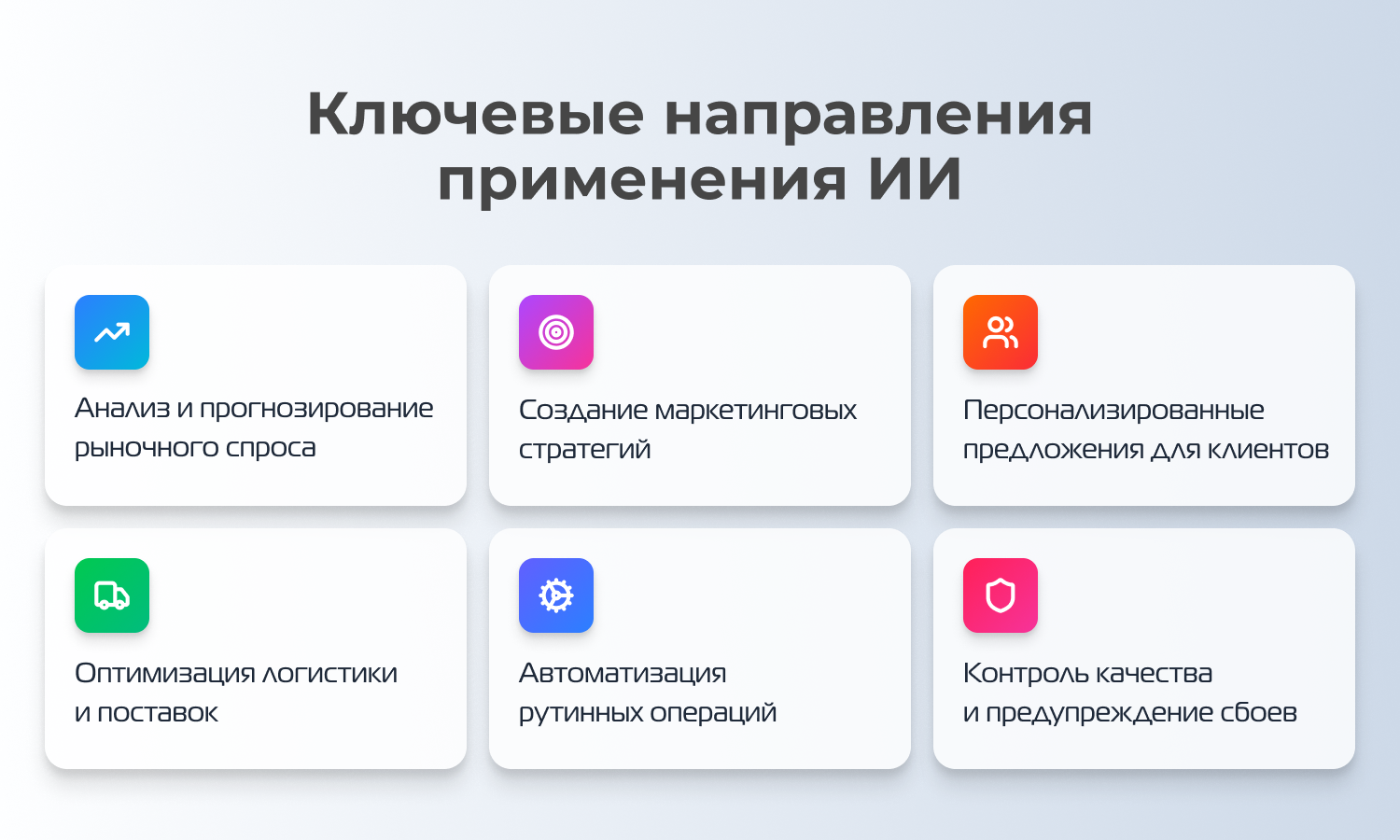

Ключевые направления применения ИИ в бизнесе в России

Российские компании все активнее интегрируют передовые технологии в свои процессы, и сфера искусственного интеллекта в бизнесе демонстрирует особенно яркие результаты. Рассмотрим ключевые векторы его практического применения.

Анализ и прогнозирование рыночного спроса — одно из наиболее востребованных направлений. Алгоритмы обрабатывают огромные массивы данных: от макроэкономических показателей до активности в соцсетях, позволяя оценивать текущий спрос и строить высокоточные прогнозы. Это минимизирует риски и открывает возможности для опережающего реагирования на изменения рынка.

Эти данные напрямую питают создание маркетинговых стратегий. Вместо интуитивных решений компании получают возможность разрабатывать кампании, основанные на поведенческих паттернах и сценарном моделировании, что значительно повышает ROI маркетинговых бюджетов.

Логичным продолжением становится формирование персонализированных предложений для клиентов. ИИ анализирует историю покупок, предпочтения и digital-след клиента, создавая уникальные, релевантные персональные офферы в реальном времени.

В операционной деятельности внедрение искусственного интеллекта в бизнес приносит осязаемую выгоду через оптимизацию логистики и поставок. Алгоритмы рассчитывают оптимальные маршруты, управляют запасами на складах, прогнозируют сроки доставки, снижая издержки и улучшая клиентский опыт.

Автоматизация рутинных операций — краеугольный камень эффективности. От обработки документов и чат-ботов до управления финансами — передача таких задач машинам высвобождает человеческие ресурсы для решения более сложных и творческих задач.

Наконец, контроль качества и предупреждение сбоев. Компьютерное зрение и предиктивная аналитика позволяют выявлять малейшие отклонения в производственных линиях, прогнозировать износ оборудования и предотвращать простои, обеспечивая бесперебойность и высокие стандарты выпускаемой продукции.

Правовое регулирование в сфере ИИ в России: текущее состояние и ключевые вопросы

Формирование нормативно-правовой базы для технологий искусственного интеллекта в России — процесс активный, но незавершенный. Отправной точкой можно считать утвержденную в 2020 году «Концепцию регулирования ИИ и робототехники». Практическим шагом к созданию «регуляторной песочницы» стал принятый годом позже Федеральный закон «Об экспериментальных правовых режимах в сфере цифровых инноваций», позволивший тестировать ИИ-решения в специальных, ограниченных правовых условиях.

Сейчас регуляторный фокус смещается на решение нескольких фундаментальных задач, от которых зависит эффективность и безопасность внедрения искусственного интеллекта в бизнес и госсектор.

Определение статуса ИИ остается первостепенной проблемой. Отсутствие в российском законодательстве юридически четкого определения искусственного интеллекта создает значительные правовые пробелы. Это затрудняет классификацию систем, разграничение их полномочий и, в конечном счете, построение целостной системы регулирования.

Центральным вопросом является ответственность за решения ИИ. Если алгоритм, применяемый в медицине, финансовой сфере или логистике, совершает ошибку с серьезными последствиями, возникает правовая дилемма: кто должен нести ответственность — разработчик, оператор системы или владелец данных? Этот пробел напрямую влияет на доверие к технологии. Отдельный аспект — авторские права. Если в рамках будущего закона «О регулировании систем искусственного интеллекта (ИИ) в России» не будут скорректированы нормы Гражданского кодекса (ст. 1257), то автором текста, изображения или кода, сгенерированного нейросетью, де-юре придется признавать пользователя, что порождает новые коллизии.

Наконец, защита данных — область на стыке регулирования. Хотя обработка персональных данных в России регулируется отдельным законом, специфика работы ИИ-алгоритмов, требующих обширных датасетов для обучения и анализа, выявляет необходимость в дополнительных правовых нормах. Речь идет о гарантиях этичного сбора данных, прозрачности их использования алгоритмом и обеспечения недискриминационного характера решений.

Правовые угрозы для бизнеса при использовании ИИ

Неопределенность в эпоху стремительного внедрения ИИ порождает конкретные юридические риски, которые владельцам и управленцам необходимо учитывать уже сегодня:

- «Галлюцинации» и юридическая ответственность

Ключевая опасность, особенно для генеративных моделей (ChatGPT, Claude и аналоги), — это склонность выдавать ложную или вымышленную информацию с высокой степенью уверенности. Для компании подобная ошибка может обернуться катастрофой: от пропуска жизненно важного судебного прецедента до заключения договора с кабальными условиями, сгенерированными самим ИИ. Масштаб проблемы глобален: только в 2024 году мировые финансовые потери от таких ошибок оценивались в $67,4 млрд.

Как минимизировать риск? Необходим тщательный анализ лицензионных соглашений с провайдерами ИИ-сервисов на предмет разделения ответственности. Для любых критически важных решений — будь то юридический документ или финансовый отчет — обязателен заключительный «человеческий контроль» профильным специалистом. Также растет рынок специализированного страхования киберрисков, где некоторые полисы начинают покрывать и убытки, вызванные сбоями искусственного интеллекта в бизнесе.

- Утечка конфиденциальных данных

Публичные ИИ-сервисы по умолчанию обучаются на вводимых пользователями данных. Беспечное общение с нейросетью может превратить ее в канал утечки коммерческой тайны, ноу-хау или персональной информации. Яркий пример — запрет на использование ChatGPT в компании Samsung в 2023 году после инцидента с утечкой секретов производства чипов. Последствия варьируются от колоссальных штрафов по регуляторным нормам (например, до 4% глобального оборота по GDPR) до необратимой потери конкурентного преимущества.

Как защититься? Решения лежат в плоскости технологической и организационной дисциплины: внедрение корпоративных ИИ-решений с локальным хранением и обработкой данных (например, российская изолированная платформа «Doczilla»), жесткие соглашения NDA с вендорами и обязательная автоматическая очистка корпоративных данных от конфиденциальной информации перед любой внешней отправкой.

- Коллизии с авторским правом и интеллектуальной собственностью

Правовые системы по всему миру только начинают определять статус контента, созданного ИИ. Прецедентные решения в США и ЕС (в частности, в 2024 году) устанавливают четкий принцип: произведения, созданные без прямого творческого вклада человека, не охраняются авторским правом. Для бизнеса это создает прямые угрозы: уникальный рекламный образ, сгенерированный в Midjourney, может быть свободно использован конкурентами, а патентная заявка, основанная на инсайте от ИИ, — оспорена или аннулирована. Это требует пересмотра подходов к созданию и защите нематериальных активов.

Как избежать рисков?

Грамотное применение искусственного интеллекта в бизнесе требует не только технологической интеграции, но и выстроенной системы управления юридическими рисками. Компании, стремящиеся к безопасному использованию этих инструментов, должны действовать на опережение.

В первую очередь, здесь важна проактивная защита интеллектуальной собственности. Чтобы сохранить эксклюзивные права на создаваемый с помощью ИИ контент, критически важно документально фиксировать творческий вклад человека. Это может быть детальный бриф, промежуточные правки дизайнера в сгенерированном изображении или авторская доработка текста. Дополнительным щитом служит выбор платформ, обученных на легальных, лицензионных данных (например, Adobe Firefly), что снижает риск претензий со стороны третьих лиц. Эти меры формируют доказательную базу для защиты ваших активов.

Не менее важен осознанный выбор, когда технологии — не панацея. Внедрение ИИ оправдано не во всех сценариях. В условиях быстро эволюционирующей судебной практики и нормативной неопределенности, особенно в высокорисковых или этически чувствительных сферах, стратегическая пауза может быть мудрым решением. В ближайшие годы сформируется устойчивая правовая база, которая расставит многие точки над i.

Уже сегодня разумным шагом является разработка внутренних регламентов, регулирующих применение искусственного интеллекта в бизнесе. А включение в команду или привлечение внешних экспертов по правовым аспектам ИИ перестает быть экзотикой. Такой комплексный подход позволяет не отказываться от инноваций, но использовать их с максимально возможной степенью защищенности.

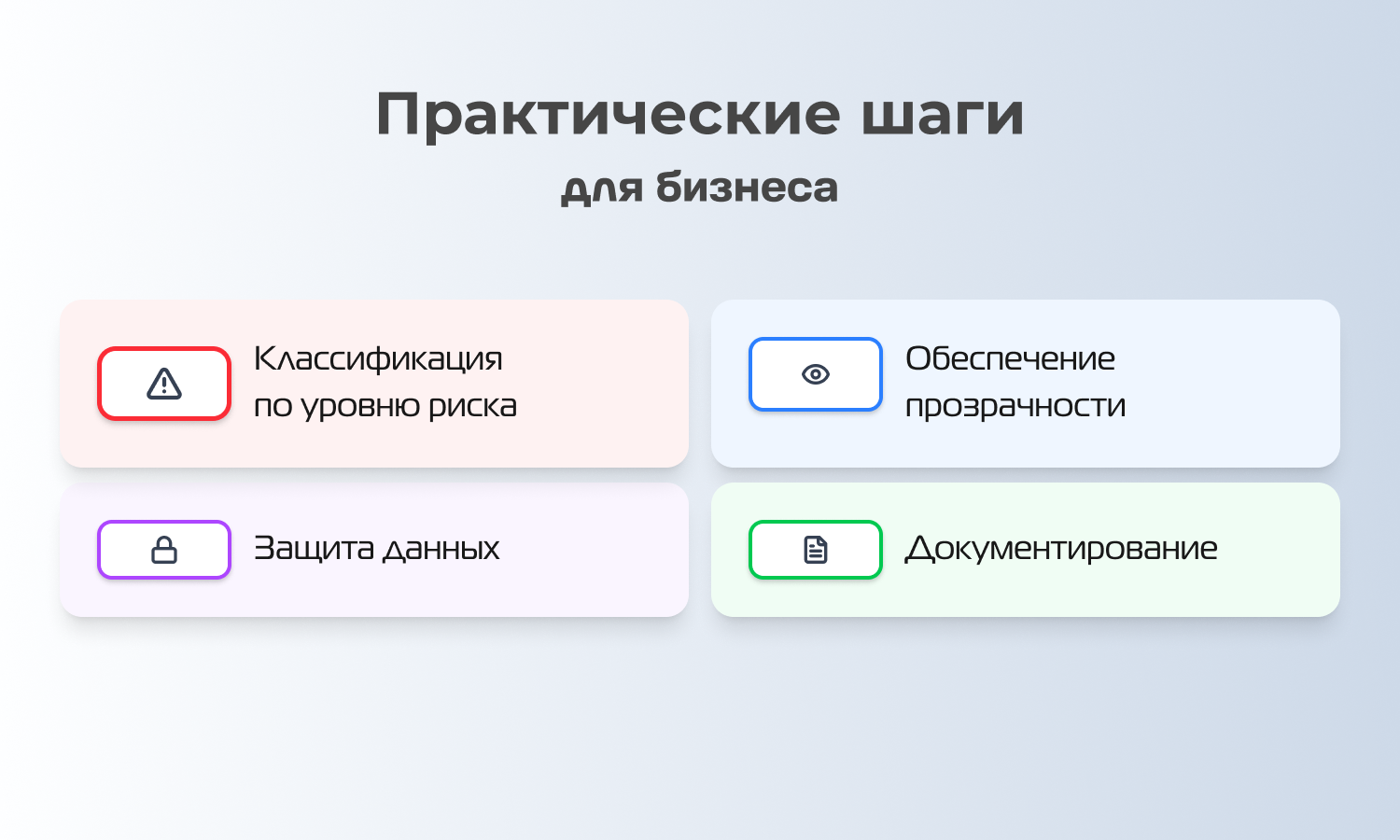

Практические шаги для бизнеса

Компаниям, которые уже практикуют использование искусственного интеллекта в бизнесе или планируют его внедрение, стоит заранее адаптировать свои процессы под ожидаемые нормы. Начать можно с нескольких системных шагов:

- Классификация систем по уровню риска

Первым практическим шагом должна стать объективная оценка потенциального воздействия внедряемых технологий. Если ИИ-решение напрямую влияет на здоровье, финансовое благополучие, карьерные перспективы или физическую безопасность людей, оно автоматически попадает в категорию высокого риска. Это же относится к применению в строго регулируемых отраслях: финансах, медицине, государственном управлении. Подобная предварительная классификация позволит понять будущий объем регуляторных требований и необходимость обязательной сертификации согласно готовящемуся закону об использовании ИИ.

- Обеспечение прозрачности и объяснимости

Одним из краеугольных камней регулирования станет требование к прозрачности. Пользователи и клиенты должны быть информированы о факте взаимодействия с алгоритмом. Особенно критично это в ситуациях, влияющих на права человека, — например, при автоматизированном отказе в кредите или отклонении резюме. Внедрение методов объяснимого ИИ (XAI), таких как SHAP или LIME, помогает сделать логику модели интерпретируемой для неспециалистов, что не только соответствует духу будущего закона, но и укрепляет доверие.

- Принципы защиты данных в новой парадигме

Безопасность данных при использовании искусственного интеллекта в бизнесе требует пересмотра. Помимо базовых мер (шифрование, регулярный аудит, принцип минимальных привилегий), необходимо оценивать риски, специфичные для машинного обучения: от реконструкции персональных данных по итогам работы модели до проблем с предвзятостью обучающих наборов. Выстраивание такой комплексной защиты заранее обеспечит соответствие не только общему законодательству о персональных данных, но и специальным нормам будущего закона об использовании ИИ.

- Дисциплина документирования

Наличие исчерпывающей технической документации — не формальность, а фундамент для диалога с регулятором. В ней должна фиксироваться вся «биография» системы: от цели создания и источников обучающих данных до метрик точности, тестирования на смещения и протоколов человеческого контроля. Даже в переходный период такая документация демонстрирует ответственный подход и формирует основу для будущего аудита или сертификации, значительно снижая юридические и репутационные риски.

Будущее ИИ в России

В глобальном контексте уже сейчас наблюдается разнонаправленность: ряд стран избирает путь жесткого нормативного сдерживания, создавая барьеры для развития технологий искусственного интеллекта в бизнесе. Российский вектор, вероятно, будет иным — не блокирующим, а структурирующим. К 2026 году можно прогнозировать несколько ключевых изменений в законодательстве, которые зададут новые правила игры:

- Уточнение авторских прав

Ожидается появление специальных норм, регулирующих статус контента, созданного нейросетями. Это может быть обязательная маркировка или детальные критерии для признания авторства, когда в процесс вовлечен человек. Это напрямую определит, как можно легально использовать результаты «творчества» ИИ в коммерции.

- Усиление ответственности разработчиков и операторов

В высокорисковых сферах, таких как медицина и финансы, могут быть введены прямые материальные санкции за вред, причиненный вследствие ошибки или предвзятости алгоритма. Это сместит фокус с экспериментального внедрения на обеспечение надежности и безопасности систем.

- Жесткое регулирование deepfake-технологий

Законодательно будет закреплен запрет на создание и распространение поддельных изображений, видео и голосовых записей без явного согласия человека. Это создаст правовые инструменты для защиты деловой репутации и частной жизни.

- Установление стандартов прозрачности

Компании, применяющие ИИ для принятия решений, затрагивающих права клиентов или сотрудников, могут быть обязаны раскрывать базовые принципы работы алгоритмов и предоставлять обоснование их выводов.

Заключение

Формирование правового поля для технологий искусственного интеллекта в России — это динамичный и сложный процесс, находящийся на стыке инноваций, экономики и права. Активное внедрение искусственного интеллекта в бизнес уже сегодня сталкивается с пробелами в вопросах ответственности, защиты данных и интеллектуальной собственности.

Ожидаемый закон об ИИ в России призван стать каркасом, который обеспечит баланс между стимулированием инноваций и защитой прав граждан и организаций. Его основные векторы — классификация систем по уровню риска, установление требований к прозрачности и безопасности — зададут новые стандарты для всей экосистемы.

Те, кто уже сегодня инвестирует в правовую экспертизу и внедряет принципы ответственного ИИ, не просто страхуются от будущих штрафов. Они формируют культуру доверия — как внутри компании, так и у клиентов и регуляторов, — что в конечном итоге станет одним из самых весомых конкурентных преимуществ в новой цифровой экономике.